Nafea Bshara, cofundadora de Annapurna Labs, conoce los semiconductores y aprecia un buen vino tinto. El distinguido ingeniero de Amazon, James Hamilton, tiene afinidad por las ideas que cambian la industria y le gusta reunirse con empresarios inteligentes.

Así es como terminaron en el histórico restaurante y bar Virginia Inn en el mercado Pike Place de Seattle hace 10 años, en el otoño de 2013, enfrascados en una conversación que en última instancia cambiaría el curso del negocio de la nube de Amazon.

Su reunión, y la eventual adquisición de Annapurna por parte de Amazon, aceleraron la iniciativa del gigante tecnológico de crear sus propios procesadores, sentando las bases para un componente clave de su actual estrategia de inteligencia artificial.

El silicio personalizado de Amazon, incluidos sus chips para inteligencia artificial avanzada, estará en el centro de atención esta semana mientras Amazon Web Services intenta reclamar su lugar en la nueva era de la IA en su re: conferencia de invención en Las Vegas.

El evento se produce dos semanas después de que Microsoft anunciara su propio par de chips personalizados, incluido el Maia AI Accelerator, diseñado con la ayuda de OpenAI, antes de la reciente agitación del fabricante ChatGPT. Microsoft describe su silicio personalizado como una “pieza final del rompecabezas” para optimizar y maximizar el rendimiento de su infraestructura en la nube.

En aplicaciones de inteligencia artificial, ChatGPT ha puesto a Amazon pisándole los talones, especialmente cuando se compara el chatbot de OpenAI con las capacidades de conversación del asistente de voz Alexa.

En la “capa intermedia” de la IA, como la llama el director ejecutivo de Amazon, Andy Jassy, Amazon busca dejar su huella con AWS Bedrock, que ofrece acceso a múltiples modelos de lenguajes grandes.

Pero la base de la estrategia de Amazon son sus chips de IA personalizados, trenio y inferenciapara entrenar y ejecutar grandes modelos de IA.

Son parte de la tendencia de las grandes plataformas en la nube que fabrican su propio silicio, optimizado para funcionar con mayor rendimiento y menor costo en sus centros de datos en todo el mundo. Aunque Microsoft acaba de hacer públicos sus planesGoogle ha desarrollado varias generaciones de sus Unidades de Procesamiento Tensoriales, utilizadas por Google Cloud para cargas de trabajo de aprendizaje automáticoy, según se informa, está trabajando en sus propios chips basados en Arm.

En el ámbito de la IA, estos chips ofrecen una alternativa al silicio de uso general. Por ejemplo, los clientes de AWS han adoptado las GPU H100 ampliamente utilizadas de Nvidia como parte de las instancias EC2 P5 de Amazon para aprendizaje profundo y computación de alto rendimiento, dijo Jassy en la conferencia telefónica sobre ganancias trimestrales de la compañía en agosto.

“Sin embargo, hasta la fecha sólo ha habido una opción viable en el mercado para todos y la oferta ha sido escasa”, añadió Jassy en ese momento. “Eso, junto con la experiencia en chips que hemos adquirido durante los últimos años, nos impulsó a comenzar a trabajar hace varios años en nuestros propios chips de IA personalizados”.

Los chips de inteligencia artificial de Amazon son parte de un linaje de silicio personalizado que se remonta a esa conversación entre Bshara y Hamilton en el stand de la esquina hace una década.

“Ese es el futuro”.

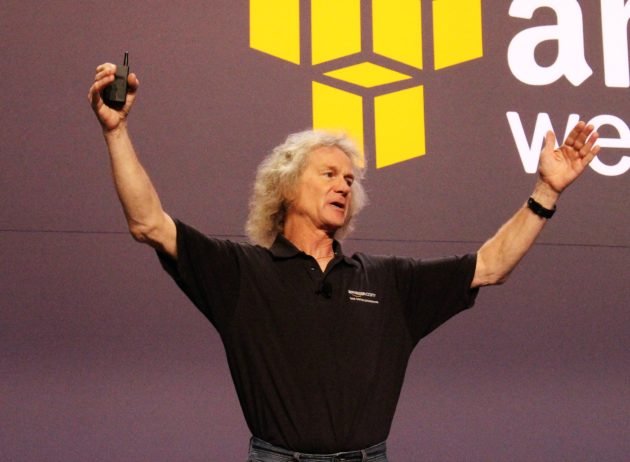

Hamilton es un ingeniero muy respetado, vicepresidente senior de Amazon que se unió al gigante de la nube procedente de Microsoft en 2010. Fue nombrado miembro del equipo de liderazgo senior de Amazon en 2021 y continúa reportando directamente a Jassy.

Al regresar al Virginia Inn para una entrevista reciente con Chinaderita y ½, Hamilton dijo que originalmente se sintió atraído por Amazon después de reconocer el potencial de Amazon S3 (Simple Storage Service) para servicios en línea. Irónicamente, esa comprensión se produjo después de que Bill Gates y Ray Ozzie de Microsoft le pidieran que experimentara escribiendo una aplicación para S3.

“Recibí esta factura justo antes de la reunión: era de 7,23 dólares. Gasté 7,23 dólares en informática, escribí esta aplicación y la probé muchísimo”, recordó. “Simplemente cambió mi vida. Me acabo de dar cuenta de que ese es el futuro”.

Fue una indicación temprana de las ventajas de precio y rendimiento disponibles para los desarrolladores y empresas en la nube. Pero después de unos años en Amazon, Hamilton se dio cuenta de que la empresa necesitaba dar otro salto.

Apenas unas semanas antes de su reunión de 2013 con Bshara, Hamilton había escrito un documento interno para Jeff Bezos y el entonces jefe de AWS, Jassy, un “escritor de seis páginas”, como los llama Amazon, defendiendo que AWS comenzara a desarrollar su propio silicio personalizado.

“Si no estamos construyendo un chip, perdemos el control para innovar”, recuerda Hamilton que pensó en ese momento, y describe la medida como la siguiente evolución natural para la empresa a medida que los servidores hacían la transición a diseños de sistema en un chip.

En su opinión, Amazon necesitaba innovar a nivel de silicio para mantener el control sobre su infraestructura y sus costos; evitar depender de otras empresas para los componentes críticos del servidor; y ofrecer más valor a los clientes mediante la creación de capacidades como seguridad y optimización de la carga de trabajo directamente en el hardware.

A medida que los procesadores Arm alcanzaban enormes volúmenes en dispositivos móviles y de Internet de las cosas, Hamilton creía que esto conduciría a mejores procesadores de servidor con más inversión en investigación y desarrollo.

Hamilton, que se levanta temprano para ir a trabajar, a menudo se reúne por las noches en pubs y restaurantes locales con nuevas empresas, clientes y proveedores para escuchar en qué están trabajando. Conocido en su momento por viajando por el mundo y trabajando desde su barcoelegiría lugares donde aparcar su bicicleta entre la oficina y el puerto deportivo.

Bshara había fundado Annapurna Labs, con sede en Israel, en 2011 con socios como Hrvoye (Billy) Bilic y Avigdor Willenz, fundador de la empresa de diseño de chips Galileo Technologies Ltd.

Un amigo en común le presentó a Hamilton y acordaron reunirse para la hora feliz, de acuerdo con la tradición de Hamilton. Bshara recuerda haber impreso una serie de diapositivas en la tienda UPS local y haberse colocado en el stand para no revelar el contenido al resto del restaurante mientras se lo mostraba a Hamilton.

Hamilton recuerda que rápidamente quedó impresionado con lo que estaba haciendo la startup israelí, reconociendo el potencial de sus diseños para formar la base de la segunda generación de chips de servidor Nitro, el caballo de batalla de Amazon, cuya primera versión había sido adaptada de un diseño existente del semiconductor Cavium. compañía.

Bshara recuerda que Hamilton, en esa reunión inicial, preguntó si Annapurna podría ir aún más lejos y desarrollar un procesador de servidor basado en Arm. El cofundador del Annapurna se mantuvo firme en aquel momento: el mercado aún no estaba preparado.

Era una señal de que estaba siendo realista y no simplemente diciendo lo que creía que el ingeniero senior de Amazon quería escuchar. Bshara siguió después de la reunión con un correo electrónico detallando su razonamiento en ese momento.

Esa fue la chispa de su asociación inicial en Nitro, que finalmente llevó a que Amazon adquiriera Annapurna en 2015 por 350 millones de dólares. Amazon dice que ahora hay más de 20 millones de chips Nitro en uso.

AWS lanzó su CPU basada en Arm, Gravitóndesarrollado por Annapurna, en 2018. Cuando decidieron fabricar el chip, Hamilton le recordó a Bshara lo que dijo sobre los servidores Arm cuando se conocieron originalmente.

“Le dije que tenías razón”, recordó Bshara, explicando que el mercado ya estaba listo.

Ventajas y desafíos de Amazon

Annapurna le dio a Amazon una ventaja temprana en un campo que puede parecer un acto de cuerda floja.

Diseñar chips es “extremadamente difícil; no se parece al software”, explicó Bshara. “No hay margen para errores. Porque si tienes un error y haces girar un chip, has perdido nueve meses. Con el software, si tienes un error, lanzas una nueva versión. Aquí tienes que imprimir una nueva versión”.

Una de las razones por las que Amazon está ansiosa por hablar de esta historia es para contrarrestar la percepción generalizada de que el auge de la inteligencia artificial generativa la tomó por sorpresa. Este será un tema recurrente en re:Invent en Las Vegas esta semana, mientras el CEO de AWS, Adam Selipsky, y su equipo muestran sus últimos productos y características.

“Queremos absolutamente ser el mejor lugar para ejecutar IA generativa”, dijo David Brown, el vicepresidente de Amazon que dirige AWS EC2 (Elastic Cloud Compute), el servicio central en el corazón de la plataforma de computación en la nube de la empresa. “Esa es un área muy amplia, si se piensa en lo que los clientes intentan hacer”.

Incluso sin utilizar los chips de inteligencia artificial de Amazon, dijo, el procesador Nitro de la compañía desempeña un papel clave en el aumento significativo del rendimiento de la red en las instancias EC2 P5 con tecnología Nvidia que se usan comúnmente para el entrenamiento de inteligencia artificial.

Pero los chips de IA personalizados le dan un nivel de control aún más granular.

“Debido a que somos dueños de todo con Trainium e Inferentia, no hay ningún problema que no podamos depurar hasta el hardware”, dijo. “Somos capaces de construir sistemas increíblemente estables a una escala enorme con silicio personalizado”.

Los chips personalizados son esenciales para las principales plataformas en la nube como AWS, Azure y Google Cloud debido a la escala masiva de las cargas de trabajo involucradas, dijo James Sandersanalista principal en Perspectiva CCS.

“Desde el punto de vista de la planificación del centro de datos, puedes empezar a tener muchos problemas simplemente colocando tantas GPU en los racks de servidores como sea posible”, dijo. “Eso se convierte en un problema de disipación de calor, se convierte en un problema de consumo de energía”.

Los chips personalizados permiten una mejor optimización de las cargas de trabajo, un menor consumo de energía y una seguridad mejorada en comparación con los chips básicos. Las GPU que consumen mucha energía también tienen algunas funciones innecesarias para las cargas de trabajo de IA. Amazon fue temprano en reconocer este hecho y tiene una ventaja en chips de IA personalizados con Trainium e Inferentia.

Sin embargo, dijo Sanders, el lado del software de la ecuación es un desafío clave.

Nvidia tiene una posición sólida en IA gracias a CUDA, su plataforma de software para informática de propósito general en GPU. Esto le dio a Nvidia un foso. Uno de los obstáculos de Amazon será lograr que las cargas de trabajo de IA se transfieran desde CUDA a las GPU de Nvidia para ejecutarlas en chips de Amazon, dijo. Esto requiere un importante esfuerzo de los desarrolladores y un mayor alcance por parte de Amazon.

Si los desarrolladores están atrapados en CUDA como lenguaje de programación, puede ser difícil sacar las cargas de trabajo existentes de las GPU de Nvidia, coincidió. Patricio Moorheaddirector ejecutivo y analista jefe de Perspectivas y estrategia de Moor, ex vicepresidente de estrategia de AMD. Describió esta perspectiva como “un trabajo muy pesado”.

Las capas de abstracción de software y las herramientas de desarrollo integradas de Amazon facilitan esta transición al iniciar nuevas cargas de trabajo, afirmó.

Bshara, cofundador de Annapurna, dijo que Amazon reconoce la importancia de la familiaridad con el software para el crecimiento a largo plazo y que la compañía está invirtiendo importantes recursos en la construcción de la cadena de herramientas de software para sus chips de IA.

“Muchos clientes ven la habilitación de Trainium como una ventaja estratégica”, dijo Bshara por correo electrónico. “Estamos entusiasmados por la rapidez con la que los clientes están adoptando estos chips y confiamos en que las herramientas y el soporte pronto serán al menos tan accesibles y familiares para los clientes como cualquier arquitectura de chip con la que hayan trabajado antes”.

Los chips de IA de la compañía son utilizados por empresas como AirBnB, Snap y Sprinklr a escala con claros beneficios de rendimiento y costos, dijo.

Anthropic también utilizará los chips de IA de Amazon en el marco de su asociación recientemente anunciada, en la que Amazon invertirá hasta 4.000 millones de dólares en la startup como contrapunto al dúo formado por Microsoft y OpenAI.

De cara al futuro, dijo Moorhead, los mayores desafíos de Amazon incluirán mantenerse a la vanguardia técnicamente con las últimas arquitecturas de chips a medida que las necesidades de modelos de IA continúan creciendo exponencialmente; y seguir invirtiendo fuertemente en I+D para competir contra empresas de chips dedicados como Nvidia y AMD.

Amazon asumió un gran riesgo al desarrollar sus propios chips, dijo Moorhead, pero dio sus frutos al restablecer la industria de los semiconductores y provocar una nueva competencia en las principales plataformas de nube. “Lo intentaron y lo lograron”, afirmó. “Y literalmente inspiraron a todos los demás a seguirlo”.